打破信息差,手把手教你本地部署 DeepSeek

在AI技术迅速发展的今天,越来越多的人开始尝试将大语言模型(如DeepSeek)应用于日常学习和工作中。然而,对于普通用户来说,如何快速、便捷地在本地环境中部署并使用这些工具仍然存在一定的门槛。再加上最近官方 deepseek 访问压力大和来源未知的大量 ddos 攻击,经常出现服务器访问繁忙的情况,使用体验并不好。

本文将以 Open Web UI 和 Ollama 为例,手把手教你完成本地部署,让你轻松实现与AI模型的交互,本教程适合新手和不具备相关行业经验的小白新手。

为什么要本地部署?

- 数据隐私:相比于在线服务,本地部署可以避免将数据上传到云端,确保敏感信息的安全性。

- 个性化配置:可以根据自己的需求调整服务参数,获得更好的使用体验。

- 低成本运行:通过开源工具和本地资源,大幅降低使用成本。

部署前的准备

在开始部署之前,请确认以下几点:

- 安装依赖:

- 确保你的系统已经安装了Python 3.11或更高版本。

- 如果你选择使用Docker,则需要先安装 Docker 和 Docker Compose。

- 网络环境:确保本地网络可以正常访问互联网,以便下载所需的软件包和镜像。

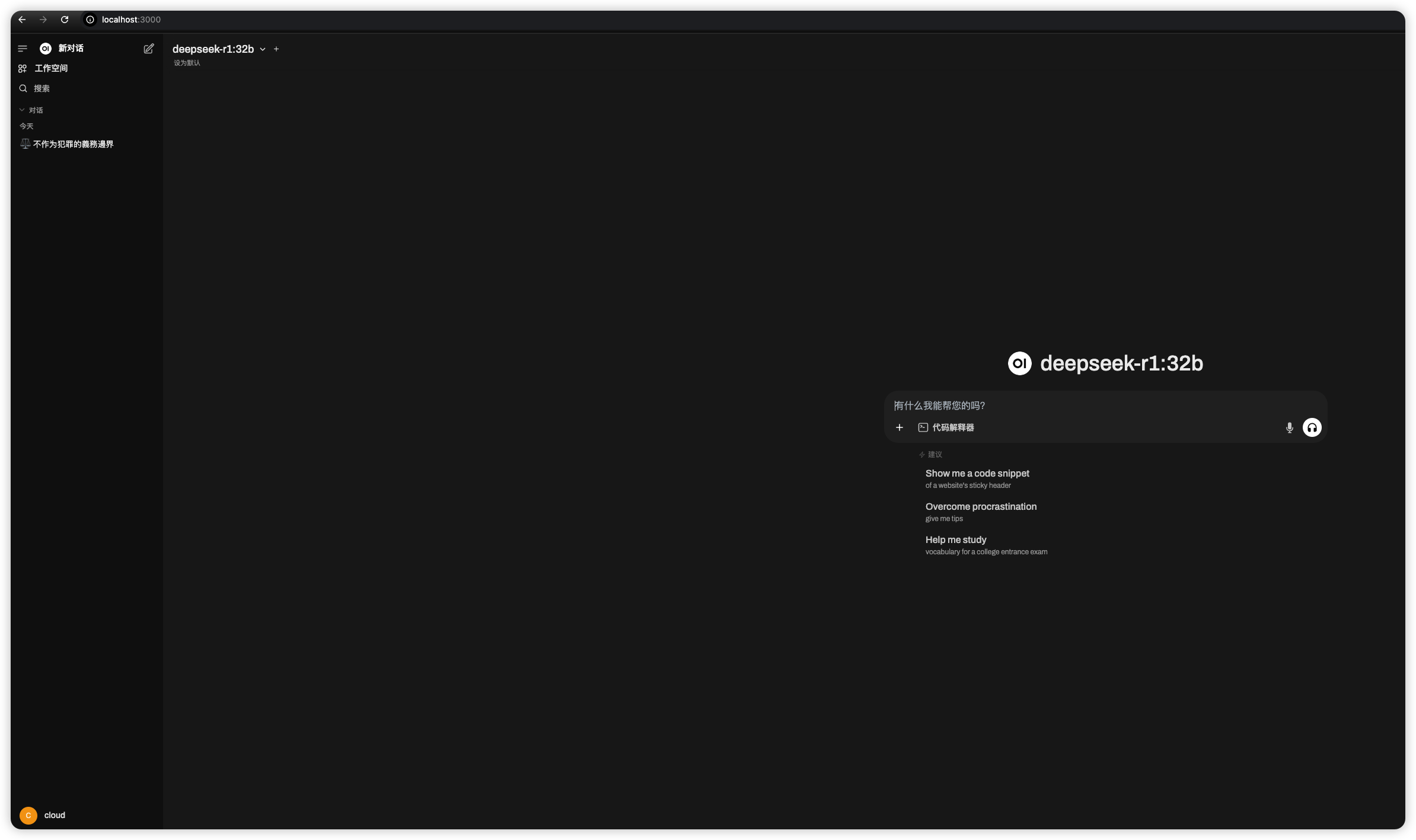

步骤一:安装并启动 Open Web UI

Open Web UI 是一个基于Web的界面工具,支持与多种AI模型(包括DeepSeek)进行交互。以下是两种常见的安装方式:

方式一:通过 pip 安装

如果你更倾向于直接在本地机器上运行服务,可以使用以下命令:

1 | pip3.11 install open-webui |

安装完成后,输入以下命令启动服务:

1 | open-webui --host 0.0.0.0 --port 3000 |

这将在本地的 localhost:3000 端口启动一个Web界面。

方式二:通过 Docker 安装(推荐)

如果你希望更简单地管理服务,可以使用 Docker。运行以下命令:

1 | docker run -d \ |

这条命令会下载并运行 Open Web UI 的Docker镜像,服务会在 localhost:3000 端口启动。

步骤二:安装并启动 Ollama

Ollama 是一个轻量级的AI模型运行工具,支持多种大语言模型。你需要先在本地安装并启动 Ollama 服务,然后将其与 Open Web UI 集成。

安装 Ollama

根据你的操作系统选择相应的安装方式:

在 Linux 上:

1 | curl -s https://ollama.ai/install.sh | bash |

在 macOS 上:

1 | brew install ollama |

在 Windows 上:

你可以通过 Ollama 官方网站 下载安装包。

启动 Ollama

安装完成后,运行以下命令启动服务:

1 | ollama serve --listen 0.0.0.0:11434 |

这样,Ollama 将在 localhost:11434 端口提供模型推理服务。

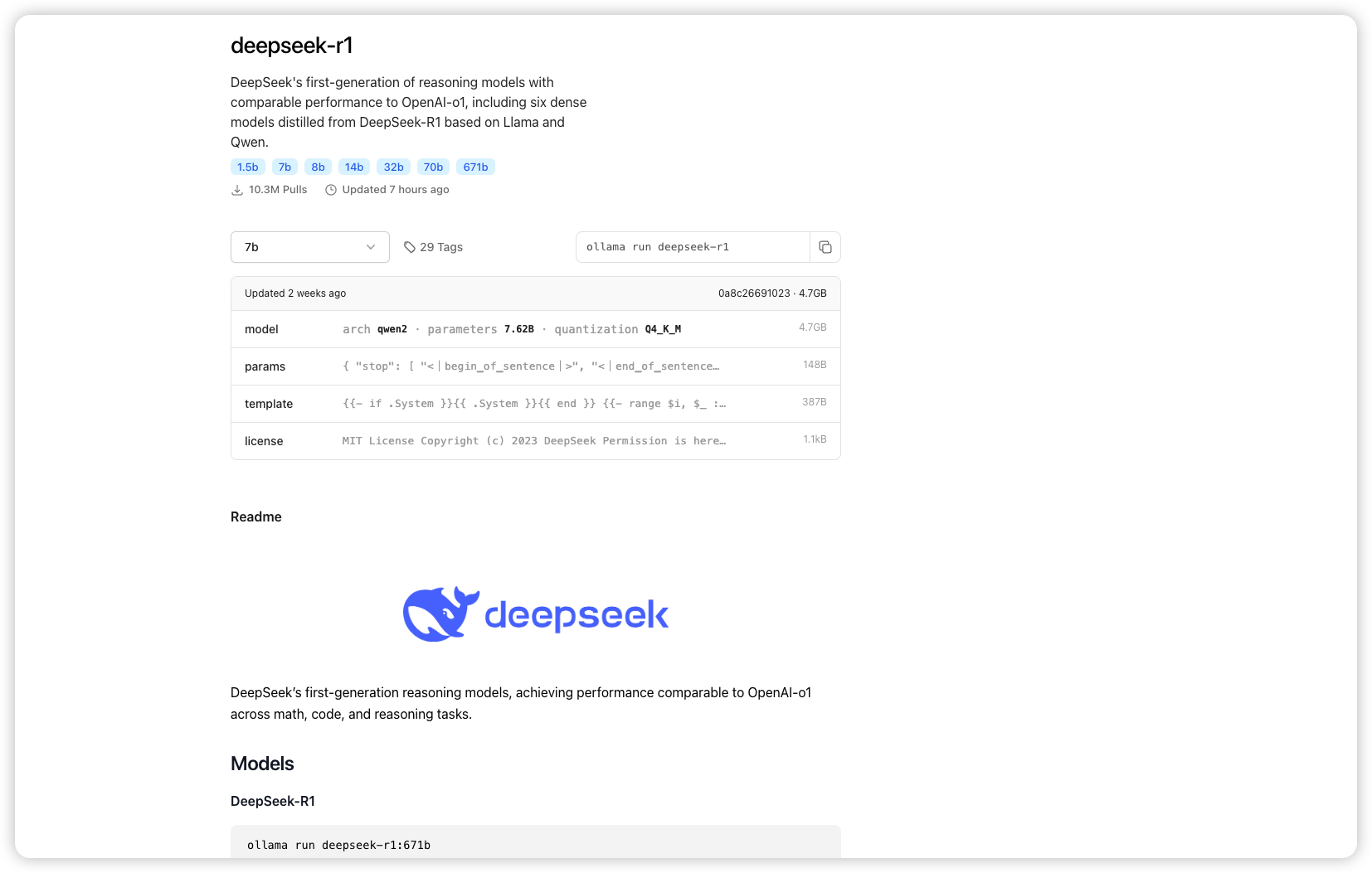

模型下载

deepseek 提供了不同参数数量的模型,比如 7b, 14b, 32b, 70b 和满血版本的 671b,这里根据你的机器配置选择不同的参数,我本地的机器是 128g 的内存,选择了 32b 的模型,仅供参考。

1 | ollama run deepseek-r1:32b |

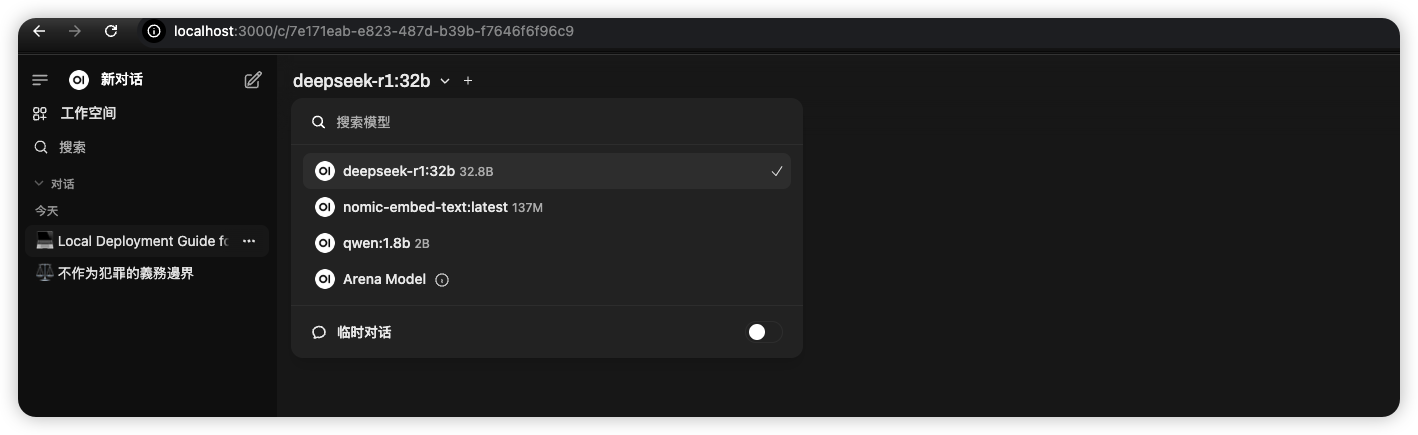

步骤三:配置 Open Web UI

启动 Open Web UI 后,访问 http://localhost:3000,你需要进行以下配置:

添加 Ollama 服务:

- 在页面上找到“Add New Model”或类似选项。

- 填写模型名称(如 DeepSeek)和地址(

http://localhost:11434/api/generate)。 - 确保勾选支持的模型类型(如文本生成、问答等)。

验证连接:

- 配置完成后,尝试发送一条简单的查询(例如“你好”)。

- 如果返回正常结果,则说明配置成功。

步骤四:测试 DeepSeek 功能

完成上述步骤后,你就可以通过 Open Web UI 使用 DeepSeek 提供的功能了。以下是几个常见的使用场景:

- 文本生成:

- 输入类似“写一篇关于人工智能的科普文章”。

- 问答交互:

- 提问:“DeepSeek 和其他大语言模型有什么区别?”

- 代码辅助:

- 输入:“帮我写一个Python脚本,用于计算斐波那契数列。”

常见问题与故障排查

服务无法启动:

- 检查端口是否被占用(如

3000或11434)。 - 确保防火墙或安全软件没有阻止相关端口的访问。

- 检查端口是否被占用(如

模型响应慢或无响应:

- 确认 Ollama 服务是否正常运行。

- 检查网络连接,确保模型可以访问互联网(部分模型依赖于在线资源)。

配置错误:

- 确保 Open Web UI 和 Ollama 的地址配置正确。

- 参考官方文档或社区论坛,获取更多帮助。

More

如果是想使用满血版本的 deepseek r1 ,目前稳定输出方案就是在硅基流动生成 API 密钥,结合 CHATBOX使用。不过该方案稍微复杂,适合有些基础的同学,感兴趣的话后面开新的教程讲一下。

总结

通过本文的指导,你已经成功在本地部署了 DeepSeek 相关服务,并可以通过 Open Web UI 与模型进行交互。这种方式不仅降低了使用成本,还提供了更高的灵活性和安全性。如果你对AI技术感兴趣,不妨尝试将这些工具应用到更多的场景中,进一步探索其潜力!